2.3.5 HA 配置(为 Mater 配置)

由于 master 只有一个, 所以也有单点故障问题.

可以启动多个 master, 先启动的处于 Active 状态, 其他的都处于 Standby 状态

步骤1: 给 spark-env.sh 添加如下配置

# 注释掉如下内容:

#SPARK_MASTER_HOST=hadoop201

#SPARK_MASTER_PORT=7077

# 添加上如下内容:

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop201:2181,hadoop202:2181,hadoop203:2181 -Dspark.deploy.zookeeper.dir=/spark"

步骤2: 分发配置文件

步骤3: 启动 Zookeeper

步骤4: 在 hadoop201 启动全部节点

sbin/start-all.sh

会在当前节点启动一个 master

步骤5: 在 hadoop202 启动一个 master

sbin/start-master.sh

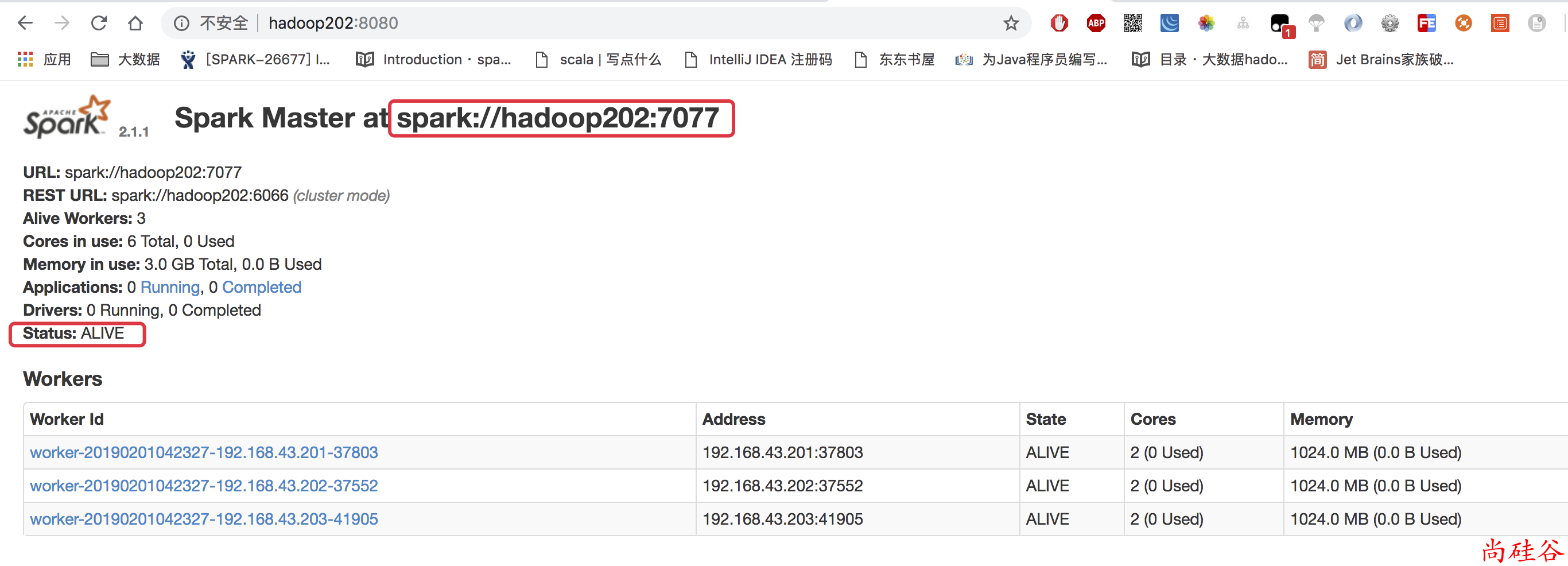

步骤6: 查看 master 的状态

步骤7: 杀死 hadoop201 的 master 进程

hadoop202 的 master 会自动切换成 Active