2.4 运行 Hive

2.4.1 运行 Hive 前必须先启动 Hadoop

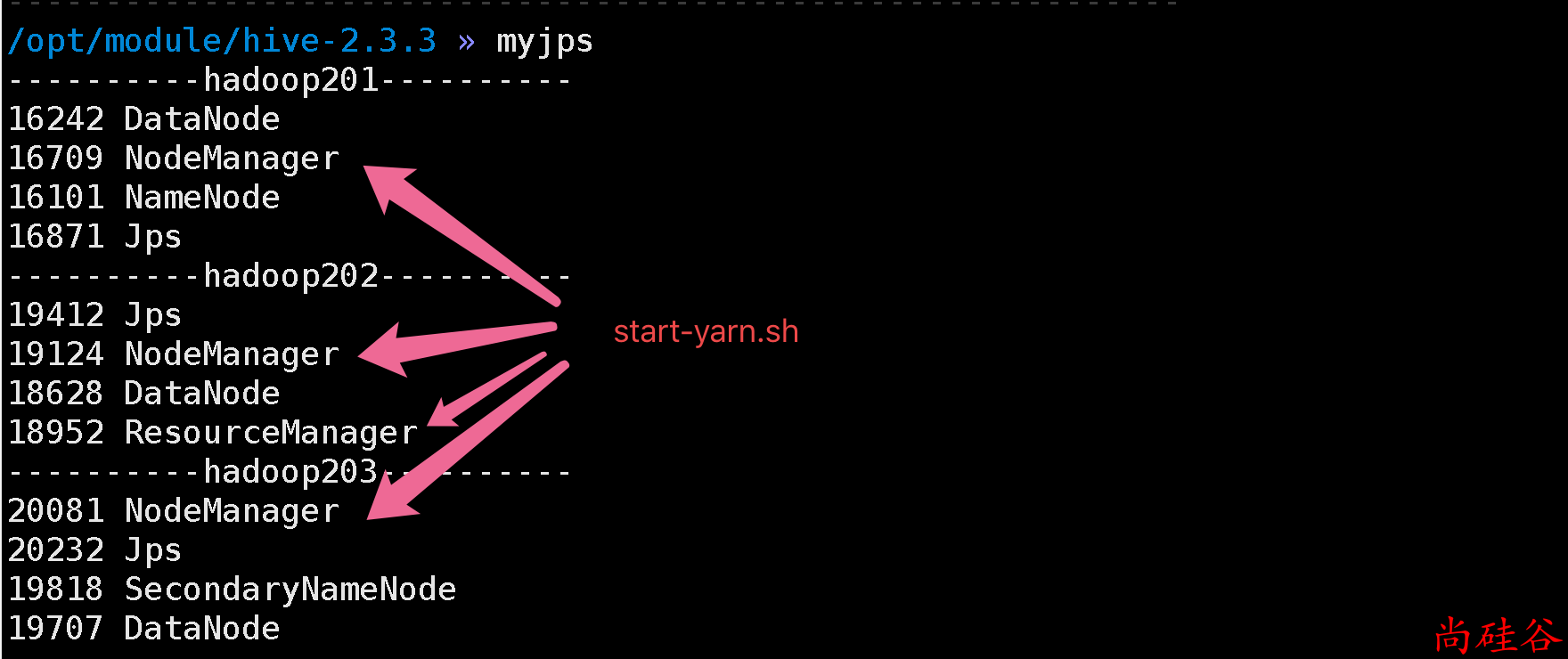

启动 Hadoop 的 HDFS 和 Yarn

在 HDFS 上创建 2 个必须的目录

运行 Hive 前必须先创建 2 个必须的目录:

/tmp和/user/hive/warehouse. 为了防止后面出现无权访问的问题, 使用777的权限hadoop fs -mkdir /tmp hadoop fs -chmod 777 /tmp hadoop fs -mkdir -p /user/hive/warehouse hadoop fs -chmod 777 /user/hive/warehouse

2.4.2 启动 Hive

启动方式1:

- 运行 Hive CLI(Command Line Interface)

由于我们已经把 Hive 的下的

/bin配置到了PATH中, 所以可以直接运行hive而进入

启动方式2:

开启一个 hiveserver2 服务器, 然后使用 beeline 客户端连接

好处: 信息展示更加友好, 更加安全, 可以通过 jdbc 远程连接

beeline 其实就是通过 jdbc 来连接到 hiveserver2

先启动 hiveserver2 服务器

hiveserver2这个是阻塞进程, 启动后控制不打印任何信息.

如果不想阻塞, 可以使其成为后台进程的方式启动:

hiveserver2 &使用 beeline 客户端连接服务器

再开启一个终端, 使用 beeline 客户端连接 hiveserver2 服务器beeline # 然后输入 !connect jdbc:hive2://hadoop201:10000 # 然后根据提示输入用户名和密码